|

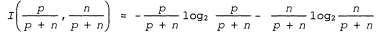

Страница 2 из 2 А если центр тяжести монеты смещен таким образом, что в 99% выпадает орел, то будет получено 1(1/100,99/100) = 0.08 битов, а поскольку вероятность выпадения орла приближается к 1, информационное содержание фактического ответа приближается к 0. Что касается обучения деревьев решений, то необходимо найти ответ на вопрос — какова правильная классификация для данного примера? Правильное дерево решений должно позволить найти ответ на этот вопрос. Оценка вероятностей возможных ответов, полученная перед тем, как будет выполнена проверка какого-либо из этих атрибутов, определяется соотношениями положительных и отрицательных примеров в обучающем множестве. Предположим, что обучающее множество включает ρ положительных примеров и η отрицательных. В таком случае оценка информации, содержащейся в правильном ответе, равна:

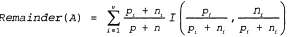

Обучающее множество для задачи с рестораном, приведенное в табл. 18.1, включает количество примеров р=п= 6, поэтому требуется 1 бит информации. Теперь отметим, что обычно проверка по одному атрибуту А не позволит нам получать такой объем информации, но по меньшей мере предоставит часть этой информации. Мы можем точно измерить, какова эта часть, определяя, сколько еще информации нам потребуется после проверки этого атрибута. Любой атрибут А делит обучающее множество Ε на подмножества в соответствии со значениями атрибута А, если А может иметь ν различных значений. Каждое подмножество в соответствии со значениями атрибута А, если А может иметь ν различных значений. Каждое подмножество  включает включает положительных примеров и положительных примеров и отрицательных примеров, поэтому после перехода по ветви этого атрибута нам потребуется дополнительно отрицательных примеров, поэтому после перехода по ветви этого атрибута нам потребуется дополнительно  битов информации, чтобы ответить на вопрос. Случайно выбранный пример из обучающего множества содержит i-e значение рассматриваемого атрибута с вероятностью битов информации, чтобы ответить на вопрос. Случайно выбранный пример из обучающего множества содержит i-e значение рассматриваемого атрибута с вероятностью , поэтому в среднем после проверки атрибута А для классификации данного примера потребуется показанное ниже количество бит информации. , поэтому в среднем после проверки атрибута А для классификации данного примера потребуется показанное ниже количество бит информации.

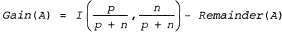

Приращение информации, полученное в результате проверки атрибута, представляет собой разность между первоначальной потребностью в информации и новой потребностью:

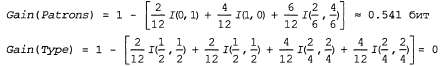

Эвристика, используемая в функции Choose-Attribute, состоит в том, что следует выбирать атрибут с наибольшим приращением. Возвращаясь к атрибутам, показанным на рис. 18.3, получаем следующее:

Эти соотношения подтверждают интуитивное предположение о том, что Patrons— наилучший атрибут, по которому следует выполнять разбиение. В действительности атрибут Patrons позволяет получить наибольшее приращение информации по сравнению с любыми другими атрибутами и должен быть выбран алгоритмом обучения дерева решений в качестве корневого.

<< В начало < Предыдущая 1 2 Следующая > В конец >>

|